Objectifs

À la fin de ce chapitre, vous pourrez :

- Expliquer le concept d’évaluation de programme;

- Mettre en œuvre une approche étape par étape pour réaliser une évaluation de programme à l’aide d’un modèle logique;

- Intégrer l’évaluation de programme dans les activités courantes de votre programme.

Introduction

L’évaluation de programme se concentre sur les questions relatives aux processus du programme (p. ex. mettons-nous en œuvre le programme tel qu’il a été conçu à l’origine?) et aux résultats (p. ex. accomplissons-nous les objectifs que nous nous sommes fixés?). Dans ce chapitre, nous fournissons des outils et des conseils pour mener une évaluation solide de votre programme de formation postdoctorale. Nous discutons de l’importance de l’évaluation de programme et décrivons comment l’intégrer dans le fonctionnement continu de votre programme.

Qu’est-ce que l’évaluation de programme?

L’évaluation de programme est définie comme l’investigation systématique de la qualité des programmes à des fins de prise de décision1. Contrairement à la recherche, qui vise à générer de nouvelles connaissances dans un domaine principalement à l’intention d’autres chercheurs, l’évaluation de programme vise à produire des renseignements utiles ou qui peuvent être utilisés par les personnes qui participent directement au programme dans le but pragmatique d’ajuster les objectifs d’un programme ou de prendre des décisions sur la poursuite ou non d’un programme dans une direction particulière. Par conséquent, l’évaluation de programme englobe des aspects de l’amélioration de la qualité, mais elle peut également examiner des questions plus larges concernant l’orientation, l’efficacité, la faisabilité et la viabilité des programmes. Il est important de se rappeler que l’évaluation d’un programme peut chercher à évaluer un programme de formation entier ou se concentrer sur des éléments spécifiques du programme qui peuvent être uniques, nouveaux ou nécessiter une révision.

Se lancer dans l’évaluation de programme en cinq étapes

Bien qu’il s’agisse d’un domaine relativement nouveau2, il existe de nombreux modèles et applications différents de l’évaluation de programme3. En nous inspirant de ces modèles, nous avons identifié cinq étapes communes que tout le monde peut utiliser pour démarrer un projet d’évaluation de programme. Si vous souhaitez un exemple précis dans le domaine de la formation médicale ou une description plus détaillée, veuillez vous reporter à Van Melle (2016)4 ou à Kaba, Van Melle, Horsley et Tavares (2019)5.

1. Mobiliser les principales parties prenantes

Une partie prenante est définie comme une personne qui a un intérêt direct dans les résultats de l’évaluation6. Puisque l’évaluation de programme se préoccupe de l’utilité ou de la garantie que les résultats de l’évaluation sont effectivement mis à profit par les principaux décideurs, il est important que les responsables de la direction, de la mise en œuvre et du fonctionnement du programme collaborent à votre évaluation de programme dès le début. L’engagement précoce est particulièrement important lorsqu’il s’agit de faire appel à des parties prenantes liées à l’équité, la diversité et l’inclusion (EDI). Il n’est peut-être pas nécessaire qu’ils fassent tous partie de votre équipe d’évaluation principale ou qu’ils soient présents à chaque réunion, mais vous voudrez les consulter et obtenir leur avis lorsque les données seront examinées et que les décisions clés concernant l’adaptation du programme seront prises. Votre première étape consiste donc à désigner les principales parties prenantes de votre programme et à vous assurer qu’elles sont incluses dans son processus d’évaluation.

2. Créer un modèle logique

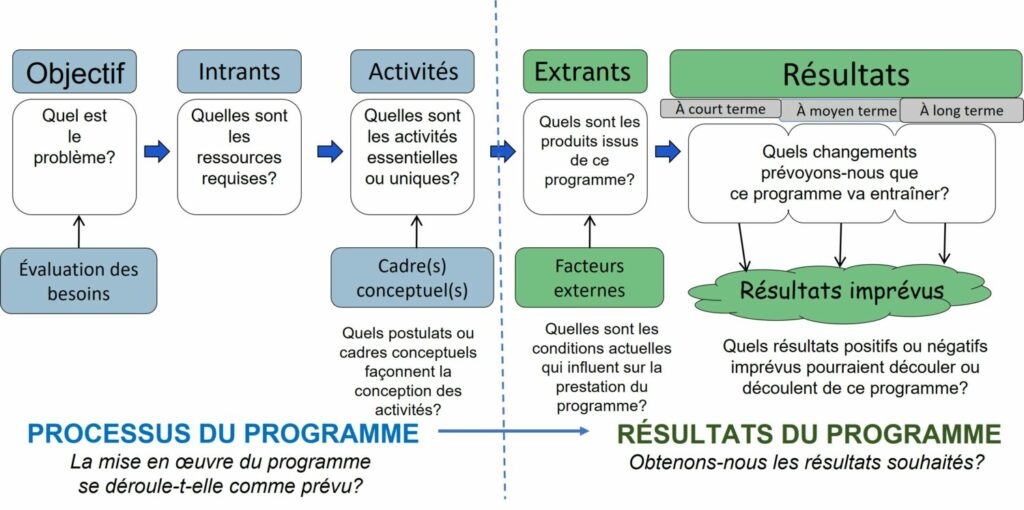

Maintenant que vous avez engagé vos principales parties prenantes, l’étape suivante consiste à désigner l’objet de votre évaluation de programme. Une évaluation de programme peut porter sur des questions relatives au processus ou aux résultats du programme. C’est là qu’intervient le modèle logique. Ce dernier est un outil couramment utilisé dans l’évaluation de programme pour comprendre comment un programme est censé fonctionner, c’est-à-dire la relation entre les composantes du programme ou le processus et les résultats du programme4 (voir figure 25.1).

Figure 25.1– Modèle logique de l’évaluation de programme. Adapté de Van Melle, E. « Using a logic model to assist in the planning, implementation and evaluation of educational programs ». Acad Med, 2016 :91-1464

Comme le montre la figure 25.1, l’évaluation des besoins constitue le point de départ de la création d’un modèle logique et permet de bien comprendre l’objectif du programme. En effectuant une évaluation des besoins, vous fournirez à vos parties prenantes la preuve qu’il vaut la peine de consacrer les ressources nécessaires à votre programme. Celles-ci sont présentées comme des intrants pour votre modèle logique. En fin de compte, ces intrants sont organisés en activités du programme. Dans le cadre de la création d’un modèle logique, il est important de désigner les activités clés ou cruciales pour la mise en œuvre de votre programme. Enfin, pour compléter l’aspect processus du programme du modèle logique, vous pouvez déterminer les concepts ou les théories sous-jacents qui vous informent sur la façon dont les activités de votre programme sont organisées.

Le côté droit du modèle logique décrit les extrants et les résultats du programme. Les extrants sont les éléments reliés au programme (p. ex. le nombre de participants, le nombre de fois où le programme a été offert). Les extrants sont simplement des indicateurs du niveau d’activité du programme. Ceux-ci peuvent être influencés par des facteurs externes tels que le moment de la mise en œuvre du programme. Les extrants ne témoignent pas de la qualité ou de l’efficacité de ces activités. C’est plutôt le rôle des résultats. En effet, ceux-ci décrivent les changements réels de comportement ou de qualités que nous attendons du programme. Par exemple, le modèle Kirkpatrick organise les résultats de tout programme de formation en quatre niveaux : (1) réaction, (2) apprentissage, (3) comportement et (4) résultats7. Chaque niveau s’appuie sur le précédent, assurant une qualité temporelle. On peut s’attendre à observer les résultats de niveau 1 (réactions) pendant l’exécution du programme ou immédiatement après, tandis que les résultats de niveau 4 se produisent en aval de la mise en œuvre du programme. Cette relation temporelle est décrite de manière générique comme des résultats à court, moyen et long terme dans le modèle logique. Enfin, les programmes étant souvent complexes, il n’est pas toujours possible d’anticiper tous les résultats possibles. Ceci est représenté par l’élément « résultats non intentionnels » de la figure 25.1.

Chaque programme sera à un stade de développement différent. Certains sont bien établis, tandis que d’autres sont encore en cours de développement. Cela deviendra évident lorsque vous aurez terminé la première version de votre modèle logique. L’objectif de cette étape n’est pas de créer un modèle logique parfait, mais plutôt de le compléter autant que possible, en laissant de la place pour d’autres versions au fur et à mesure que l’évaluation progresse.

3. Prioriser vos questions d’évaluation

Pendant que vous compléterez votre modèle logique, il deviendra évident que vous pouvez poser de nombreuses questions d’évaluation différentes qui dépassent de loin l’examen des résultats. En travaillant de gauche à droite sur le modèle logique, vous pourriez vous poser les questions suivantes :

Sommes-nous vraiment convaincus de la nécessité de ce programme? Si c’est le cas, vous pourriez vous concentrer sur la réalisation d’une évaluation des besoins en tant que priorité pour l’évaluation de votre programme.

Disposons-nous de ressources suffisantes pour mettre en œuvre ce programme? Si tel est le cas, vous pourriez vous concentrer sur l’examen des intrants.

Mettons-nous en œuvre notre programme comme prévu? Si c’est le cas, vous pourriez vous concentrer sur l’examen du fonctionnement réel du programme. C’est ce qu’on appelle souvent la fidélité de la mise en œuvre8.

Ces questions s’inscrivent dans le cadre d’une évaluation des processus. En ce qui concerne les résultats, vous pourriez vous poser les questions suivantes :

Que produit notre programme? Ici, vous pourriez vous concentrer sur l’examen des chiffres ou des résultats réels associés à votre programme.

Réalisons-nous les changements spécifiques que nous nous sommes fixés? Si tel est le cas, vous pourriez recueillir des données sur les changements spécifiques qui peuvent être attribués au programme.

Enfin, il est important de se rappeler que vous ne pouvez pas tout prévoir lorsque vous créez un modèle logique. Vous pourriez avoir le sentiment de voir émerger certains résultats non intentionnels qu’il est important de saisir.

Compte tenu des multiples possibilités, il est important de classer par ordre de priorité, avec vos principales parties prenantes, la ou les principales questions d’évaluation, en gardant à l’esprit qu’une bonne question d’évaluation doit :

- aborder une question qui préoccupe les parties prenantes de votre programme;

- pouvoir faire l’objet d’une réponse (elles ne sont pas philosophiques ou morales);

- informer en temps utile de l’avancement de votre programme;

- pouvoir être examinée;

- être formulée de manière neutre (elle ne doit pas présumer d’un résultat positif ou négatif).

En outre, considérez la ou les questions d’évaluation qu’il peut être important d’élaborer dans l’optique de l’EDI. Quelles sont les voix qui ne sont pas adéquatement représentées dans votre groupe de parties prenantes ou votre programme? Quelles sont les difficultés rencontrées par les résidents sous-représentés ou marginalisés? Avez-vous fait participer divers résidents en tant que parties prenantes à l’élaboration de la ou des questions d’évaluation?

4. Collecter vos données

Tout comme pour la recherche, il est important que votre méthode de collecte de données corresponde à la nature de votre question d’évaluation. Par exemple, si vous recueillez des perceptions ou si vous vous concentrez sur des voix sous-représentées, les approches qualitatives sont probablement les meilleures. Si, en revanche, vous vous intéressez aux différents types de comportements adoptés à la suite de votre programme, vous souhaiterez peut-être utiliser une approche plus quantitative. Et bien sûr, vous avez toujours l’option d’utiliser des méthodes mixtes, où les méthodes qualitatives et quantitatives sont délibérément combinées. Quelle que soit la méthode choisie, l’équilibre entre la faisabilité et la crédibilité d’une part, et l’aspect pratique d’autre part, est un aspect essentiel de l’évaluation de programme. Contrairement à la recherche, où vous pouvez recueillir des données sur une longue période, l’évaluation de programme repose sur la collecte de données en temps voulu dans le but d’améliorer la prise de décisions. Le défi consiste à s’assurer que les méthodes que vous utilisez sont bien pensées et équilibrées, compte tenu de la nécessité de collecter les données en temps voulu.

5. Agir en fonction de vos résultats et les communiquer

L’interprétation des données doit être menée conjointement avec toutes les parties prenantes à des moments clés de l’évaluation du programme. Cette approche maximise la probabilité que les résultats conduisent effectivement à des changements de programme. Plus tôt et plus souvent vous pouvez inciter vos parties prenantes à donner un sens aux données et à agir en conséquence, mieux c’est. En outre, le fait de renvoyer les données aux parties prenantes auprès desquelles elles ont été recueillies indique que vous accordez de l’importance à leurs opinions ou à leurs expériences; cela peut avoir un effet remarquable sur le processus de mise en œuvre9. De plus, pour les questions axées sur l’EDI, qui peuvent contenir des données sensibles difficiles à rendre anonymes, il est prudent de demander au participant ou aux parties prenantes des conseils sur la façon de discuter de ces renseignements d’une manière psychologiquement sûre.

Il peut arriver que vous souhaitiez publier vos résultats dans le cadre d’un processus d’évaluation par les pairs et que vous hésitiez donc à partager officiellement vos résultats dès le début. En effet, une évaluation de programme qui possède un cadre conceptuel clair ou une « théorie du changement10,11 » et qui s’appuie sur la littérature existante devrait être considérée comme une étude pédagogique et donc adaptée à la publication12. La rédaction d’un rapport technique dans lequel vous décrivez vos progrès en temps voulu, mais n’incluez pas tous les détails, tels que les méthodes spécifiques ou les implications, vous permet de communiquer vos résultats dans le cadre d’une évaluation de programme tout en gardant l’option de publier officiellement vos efforts d’évaluation ultérieurement.

Renforcer la capacité d’évaluation de programme

Étant donné que les programmes sont en constante évolution, il est préférable que l’évaluation de programme soit un processus continu5,8. Vous pouvez donc envisager des moyens d’intégrer l’évaluation de programme en tant qu’activité permanente dans le fonctionnement de votre programme.

Conseils pratiques

Votre modèle logique évoluera au fil du temps

En créant un modèle logique, il s’agit simplement de lancer la discussion. Concentrez-vous donc sur la création d’un modèle logique « suffisamment bon » et qualifiez-le d’ébauche. Vous continuerez probablement à discuter de votre modèle logique et à le réviser, et à en créer de nouvelles versions au fur et à mesure de l’évaluation de votre programme et de son évolution. La création et le partage de votre projet de modèle logique constituent un excellent moyen d’obtenir un engagement continu et l’adhésion de toutes les parties prenantes.

Faites appel à l’expertise

L’évaluation de programme exige une expertise à laquelle vous n’avez peut-être pas accès immédiatement au sein de votre programme. Dans de nombreux centres hospitaliers universitaires, il est possible d’accéder à l’expertise en matière d’évaluation par l’intermédiaire de différents départements (p. ex. éducation, santé publique, santé communautaire et épidémiologie, comités d’action sur l’inclusion et l’antiracisme). Il n’est pas nécessaire que des personnes possédant cette expertise fassent partie de votre groupe central de parties prenantes, mais il vaut la peine d’aller à l’extérieur du groupe pour obtenir des conseils qui peuvent vous aider dans l’évaluation de votre programme.

Simplifiez l’évaluation de votre programme

Il se peut qu’il faille trouver un compromis entre la réalisation de l’évaluation parfaite du programme, le travail avec les ressources disponibles et la création de données en temps voulu pour la prise de décisions. Une bonne règle de base est de garder votre évaluation simple, en reconnaissant qu’il s’agit d’un processus itératif. Des possibilités d’amélioration seront toujours envisageables. L’objectif principal est de générer un processus et des données permettant d’éclairer la prise de décisions.

Conclusion

L’évaluation de programme est un domaine spécifique distinct de la recherche et de l’amélioration de la qualité dans la mesure où l’objectif principal est toujours de fournir des données en temps voulu pour la prise de décisions et l’adaptation des programmes. Pour s’assurer que les résultats sont mis à profit, l’engagement des parties prenantes est une caractéristique essentielle d’une évaluation de programme solide. Une évaluation de programme peut englober de nombreuses questions différentes examinant à la fois les processus et les résultats du programme. L’évaluation d’un programme peut donc être entreprise à tout moment de son développement.

Références

- Yarborough, D. B., L. M. Shulha, R. K. Hopson et F. A. Caruthurs The program evaluation standards, 3eéd., Thousand Oaks (CA), Sage Publications, 2011. p. xxv.

- Fitzpatrick, J. L., J. R. Sanders et B. R. Worthen Program evaluation: alternative approaches and practical guidelines.. 3eéd., Boston (MA), Pearson Education, 2004.

- Stufflebeam, D. L. et C. L. S. Coryn Evaluation theory, models & applications. San Francisco (CA): Jossey-Bass; 2014.

- Van Melle, E. « Using a logic model to assist in the planning, implementation and evaluation of educational programs ». Acad Med, 2016 :91-1464

- Kaba, A., E. Van Melle, T. Horsley et W. Tavares Evaluating simulation programs throughout the program development life cycle. Chap. 59, dans G. Chiniara, éditeur. Clinical simulation: education, operations and engineering. 2eéd., San Diego (CA), Academic Press, 2019.

- Patton, M. Q. Essentials of utilization-focused evaluation. Thousand Oaks (CA), Sage Publications, 2012. P. 66.

- Kirkpatrick, D. L. et J. D. Kirkpatrick Evaluating training programs: the four levels. 3eéd., San Francisco (CA), Berrett-Koeler Publishers, 2006.

- Hall, A. K., J. V. Rich, D. Dagnone, K. Weersink, J. Caudle, J. Sherbino et coll. « It’s a marathon, not a sprint: rapid evaluation of CBME program implementation ». Acad Med. 2020;95(5):786–793.

- Funnell, S. C., P. J. Rogers Purposeful program theory: effective use of theories of change and logic models. San Francisco (CA), Jossey-Bass, 2011.

- Bordage, G. « Conceptual frameworks that illuminate and magnify ». Med Educ. 2009;43:312-319.

- Van Melle E., J. Lockyer, V. Curran, S. Lieff, C. St. Onge et M. Goldszmidt, « Toward a common understanding: supporting and promoting education scholarship for medical school faculty ». Med Educ. 2014;48:1190-1200.