Objectifs

À la fin de ce chapitre, vous pourrez :

- planifier des activités d’apprentissage qui suivent les cinq étapes de la conception des programmes d’études;

- expliquer pourquoi le fait de disposer au départ de résultats de programme bien définis aide à planifier des programmes d’études.

Scénario

Le Dr Tremblay dirige un programme d’anatomo-pathologie de 20 résidents. Il a constaté que certains ne progressent pas dans l’activité professionnelle confiable (APC) de maîtrise de la discipline : « Présenter des cas à des conférences multidisciplinaires sur le cancer ». Pour mieux comprendre les défis rencontrés, il visite le tableau de bord du portfolio électronique et ne trouve que très peu d’observations où les résidents ont effectué cette APC, même à la fin de l’étape de maîtrise de la discipline. Cette tendance ne concernant que cette APC, le Dr Tremblay croit que le faible rendement des résidents s’explique par leur difficulté à communiquer avec des collègues cliniciens ou à s’adresser à des auditoires multidisciplinaires. Il décide de s’attaquer à ce problème. Il invite sa collègue, la Dre Nguyen, efficace représentante de l’anatomo-pathologie aux réunions de comité de thérapie du cancer, à réfléchir autour d’un café. Il lui expose son plan initial : inviter un représentant du bureau du perfectionnement du corps professoral à animer un atelier sur les habiletés de communication, et l’inviter elle à donner une conférence sur la façon de préparer et de présenter des cas aux réunions de comité de thérapie du cancer. Après un court silence, la Dre Nguyen lui demande : « Savez-vous pourquoi leurs évaluations sont faibles? Si votre diagnostic est erroné, vous traitez une maladie qui n’existe pas, et les symptômes, eux, demeurent. »

Introduction

Quel est le résultat visé de l’activité que vous prévoyez? Qu’il s’agisse d’un problème à résoudre, d’une nouvelle APC à exécuter ou d’un objectif à atteindre, l’aspect le plus important de la conception d’une activité d’apprentissage est d’avoir le résultat visé en tête. Dans l’approche par compétences en formation médicale, les résultats escomptés doivent être formulés sous forme de comportements mesurables, d’aptitudes bien définies dont l’apprenant pourra faire la démonstration comme résultat de son apprentissage1,2. Dans notre scénario, le résultat visé n’est pas d’obtenir des évaluations élevées à une APC, mais de savoir représenter l’anatomo-pathologie à des réunions de comité de thérapie du cancer. En ayant le résultat visé en tête, il est possible de cerner le défi réel, de corriger le tir et de trouver une voie pour atteindre l’objectif final.

Les cinq étapes de la conception des programmes d’études1 peuvent s’appliquer aux besoins éducatifs variés auxquels un directeur de programme doit satisfaire1. Elles peuvent vous aider à préparer une rencontre clinique individuelle en milieu de travail, à concevoir une activité d’apprentissage unique, à organiser une demi‑journée universitaire, à créer un nouveau stage clinique ou à restructurer un programme de résidence complet, comme lors du déploiement de La compétence par conception. Quelle que soit l’activité à créer ou à améliorer, vous devez d’abord cerner et comprendre le problème à résoudre. Quel résultat visez-vous? Y a-t-il un (réel) problème? Le cas échéant, lequel? Mérite-t-il d’y consacrer vos ressources limitées (dont la plus rare : le temps)? Une activité d’apprentissage vous aidera-t‑elle à résoudre ce problème ou à atteindre le résultat visé? Une fois que vous avez pris la décision d’aborder de front un objectif d’apprentissage bien circonscrit, cinq étapes vous aideront à atteindre efficacement vos objectifs.

Les cinq étapes de la conception des programmes d’études

1. Effectuez une évaluation des besoins

Si vous décidez qu’une activité d’apprentissage est la bonne façon de résoudre votre problème, c’est que vous avez conclu que le rendement de vos apprenants pouvait s’améliorer en travaillant leurs connaissances, leurs habiletés ou leur attitude. Vous devez comprendre pourquoi leur rendement est médiocre ou les nouvelles compétences qu’ils doivent développer. Grâce à votre expertise, la simple observation de la situation et des symptômes vous en donne un bon aperçu, mais il reste à faire l’anamnèse, l’examen physique et peut-être quelques examens ou à discuter avec un collègue pour confirmer que vous avez bien mis le doigt sur la cause du problème. Comme l’illustre le scénario, si vous posez le mauvais diagnostic, vous prescrirez le mauvais traitement et vous n’atteindrez pas les résultats d’apprentissage escomptés.

Il existe une panoplie d’outils et de stratégies pour cerner précisément les lacunes d’apprentissage. Comme personne n’est fiable pour évaluer son propre rendement, il vaut mieux recueillir des données externes, comme les opinions d’experts (demandez à vos collègues) ou les marqueurs de rendement (indicateurs de qualité, précédentes évaluations, vérification de dossiers)1,3. Vous pouvez aussi évaluer le rendement de vos résidents pour le problème qui vous occupe par des questions à choix multiple de réponses ou de la rétroaction multisource. L’évaluation du rendement de vos résidents vous aidera à déterminer si le problème réside dans les connaissances, les aptitudes, l’attitude ou une combinaison des trois1,3.

Enfin, il est essentiel de faire participer les apprenants. Jauger le problème de leur point de vue donnera une validité apparente aux processus, mais, aussi et surtout, vous montrera leur perception de leur propre attitude, du curriculum caché et du milieu d’apprentissage. Des questionnaires (sondages électroniques) ou des groupes de discussion peuvent vous aider à atteindre cet objectif. Quel que soit l’outil choisi, faites-vous aider par des experts. Commencez par consulter le bureau de la formation médicale postdoctorale ou le service de la formation médicale de votre établissement.

Il importe aussi de reconnaître d’abord que certains résidents peuvent ne pas se rendre compte qu’il existe un problème, en particulier s’il ne les touche pas directement. Par exemple, les résidents peuvent ne pas reconnaître jusqu’à quel point le racisme dans le système de soins de santé peut nuire à leurs patients et à leurs collègues non-blancs (personnes autochtones, noires et de couleur). Un engagement ciblé auprès des résidents ou des communautés est également important pour mieux connaître les enjeux liés à l’équité, la diversité et l’inclusion (EDI). Aussi, vous situer par rapport à un enjeu (p. ex., DP cisgenre abordant un problème de soins aux personnes LGBTQ+) devrait vous amener à collaborer avec d’autres personnes qui en savent plus ou qui ont acquis de l’expérience dans ce domaine.

2. Créer des objectifs d’apprentissage

Une fois le problème circonscrit et les lacunes d’apprentissage à combler cernées, vous devez formuler ce que vos apprenants seront en mesure de faire après avoir terminé l’activité d’apprentissage que vous planifiez : ce sont vos objectifs d’apprentissage. Demandez à votre équipe ou demandez-vous si le problème sera résolu si les apprenants acquièrent ces compétences. Les objectifs d’apprentissage doivent combler les besoins et être très précis. Ne visez pas ce que les enseignants veulent transmettre, mais ce que les apprenants ont besoin d’apprendre. Ce sont les concepteurs des programmes d’études qui doivent fournir les objectifs d’apprentissage à l’animateur de l’activité.

Le processus se trouve résumé par l’acronyme courant SMART. Les objectifs d’apprentissage doivent être spécifiques (ils doivent combler les lacunes d’apprentissage particulières que vous avez découvertes); mesurables par une forme quelconque d’évaluation (que vous allez créer); atteignables par les apprenants à l’aide des ressources dont ils disposent (il faut tenir compte de l’ampleur des lacunes, et du temps, des fonds, de l’espace, du facteur humain, etc., disponibles). Ils doivent être réalistes par rapport au problème initial et aux objectifs du programme (l’activité d’apprentissage va-t-elle résoudre le problème?) et, enfin, temporels pour savoir quand attendre des résultats (c’est-à-dire, à la fin d’une conférence, d’une série d’ateliers ou d’un stage complet)4.

Selon les besoins, les objectifs d’apprentissage peuvent cibler des domaines différents (cognitifs, psychomoteurs ou affectifs). Ils doivent être conçus de manière progressive pour permettre aux apprenants de gravir les échelons des aptitudes au fil de l’activité d’apprentissage. Les principes de Bloom catégorisant les objectifs d’apprentissage constituent l’un des cadres conceptuels les plus utilisés pour rédiger des objectifs de manière séquentielle, des connaissances factuelles et de la compréhension des concepts à leur application à la résolution de problèmes et à l’analyse de scénarios réels ou simulés, selon le stade de développement des apprenants5. Cette classification propose une liste de verbes d’action qui doivent correspondre à l’aptitude que vous voulez observer chez les apprenants après votre intervention d’apprentissage.

3. Choisir les modes d’enseignement appropriés

Une des pratiques les plus courantes (mais des plus inefficaces) de conception des programmes d’études consiste à amorcer la planification par le choix de la méthode d’enseignement, soit, généralement, par défaut, une conférence. Rien de surprenant : une conférence permet aux intervenants de transmettre de l’information; c’est une forme bien connue des enseignants et des apprenants; elle est facile à préparer et à présenter, et il est simple d’y assister; la disposition des salles de classe s’y prête bien; elle nécessite peu de ressources et la logistique est assez simple; l’évaluation des apprenants et de l’intervention est aisée. C’est une solution facile (agrément, liste de choses à faire qui diminue, bonne conscience, etc.) et votre niveau d’anxiété baissera sans doute puisque vous aurez l’impression d’avoir réglé le problème. Cela étant, si les apprenants assistent à une conférence, leurs besoins seront-ils comblés? Auront-ils acquis les aptitudes que vous avez décrites dans les résultats du programme d’apprentissage? Leur rendement va-t-il changer? Le problème détecté sera-t-il réglé? Dans la plupart des cas, les conférences sont des traitements en vente libre des symptômes qui ne s’attaquent pas au problème à la racine. De plus, ce n’est pas le meilleur usage à faire de la valeur ajoutée de vos enseignants (leur expérience) ou de la ressource la plus rare qui soit (le temps)! De nos jours, l’information est largement accessible, et le rôle principal des enseignants est d’utiliser leur expertise pratique pour faciliter la transmission des connaissances et accompagner les stagiaires, pas de donner de l’information.

Les méthodes d’enseignement doivent être en adéquation avec les objectifs d’apprentissage qui, eux, doivent combler les besoins des apprenants pour que leur rendement s’améliore et que le problème soit résolu1,3. De prime abord, le choix de méthodes d’enseignement semble simple, mais il est important d’élargir la palette proposée par votre programme et de diversifier vos outils1,3. Pour des connaissances factuelles, un texte à lire ou un tutoriel à visionner peut faire l’affaire; pour la compréhension, une classe inversée ou une conférence interactive suffira probablement; pour l’application de connaissances, vous pourrez avoir besoin de discuter des cas ou d’organiser des jeux de rôles; les exercices de simulation sont probablement les plus à même d’évaluer les aptitudes psychomotrices; et pour favoriser un changement d’attitude sur un sujet sensible en milieu de travail, vous pourriez avoir besoin d’offrir un accompagnement (coaching) longitudinal. Il existe un grand nombre de ressources pour vous aider à choisir la méthode la plus appropriée pour remplir vos objectifs1,3. Le service de perfectionnement du corps professoral et le bureau de la formation médicale postdoctorale de votre établissement sont des sources inestimables où puiser de l’aide pour mettre en place de nouvelles méthodes.

En commençant à appliquer ces étapes, vous réaliserez peut-être qu’un certain nombre d’interventions d’apprentissage espacées et variées seront nécessaires pour régler votre problème. Alors que vous pensiez au départ vous en sortir avec une conférence, il vous faut maintenant suivre un long cheminement vers le nirvana. Ne vous découragez pas! Faire entrer de force des objectifs irréalistes dans une séance d’enseignement passif, unimodal et unidirectionnel d’une heure est malheureusement une pratique éducative bien ancrée depuis des temps immémoriaux, mais un enseignement efficace est le résultat d’un processus délibéré et bien conçu. Et vous voilà à la barre de ce projet!

4. Évaluer le rendement des apprenants

En éducation, l’évaluation a deux niveaux : l’évaluation des apprenants et l’évaluation des programmes (qui sera abordé dans la cinquième étape ci-dessous). Il existe une grande variété de méthodes et d’instruments d’évaluation qui tentent tous essentiellement de répondre à la même question : les apprenants sont-ils en mesure de démontrer les résultats attendus du programme d’études ou les compétences souhaitées? Par conséquent, vos méthodes d’évaluation doivent mesurer l’atteinte, par l’apprenant, d’objectifs d’apprentissage spécifiques de l’activité : les connaissances factuelles et la compréhension se mesurent par des questions à choix multiple de réponses ou des questions à réponse courte; l’application des connaissances s’évalue par des examens oraux, accompagnés de discussions de cas; les aptitudes psychomotrices peuvent s’observer lors d’exercices de simulation; la rétroaction multisource offrira la meilleure évaluation des habiletés de communication et de collaboration; et le rendement d’une activité professionnelle confiable (APC) du début à la fin nécessite généralement une observation en milieu de travail6. Encore une fois, vous devrez probablement élargir votre palette d’évaluation et combiner différentes méthodes selon les objectifs d’apprentissage de l’activité. Il existe des lignes directrices simples qui vous aideront à trouver les bonnes méthodes d’évaluation et qui vous faciliteront la tâche6. Tel qu’il a été conseillé au sujet de l’évaluation des besoins, il s’agit d’une autre occasion importante de réfléchir à la position des évaluateurs sur le rendement des résidents et de ses effets sur l’évaluation.

L’évaluation est une science vaste et complexe, mais certains grands principes généraux peuvent s’appliquer à toute situation d’évaluation. L’acronyme CARVE désigne l’un des cadres utilisés7 :

- Coût : Quels sont les efforts et les ressources nécessaires à cette entreprise? (N’oubliez pas de comptabiliser le temps nécessaire.)

- Acceptabilité : Est-elle acceptable pour les apprenants, pour les enseignants et pour les autres intervenants?

- Répétabilité (= fiabilité) : Produit-elle les mêmes résultats chaque fois qu’on l’évalue?

- Validité : Évalue-t-elle ce qu’elle doit évaluer?

- Effets éducatifs : A-t-elle permis de résoudre votre problème?

Le déploiement de La compétence par conception (CPC) pour la formation médicale postdoctorale (FMPD) à l’échelle du pays a fait de l’évaluation en milieu de travail la pierre angulaire de tout programme d’évaluation2. Elle nécessite l’observation du rendement des résidents pendant qu’ils accomplissent leurs APC. Ces observations permettent aux superviseurs de faire appel à leur expérience et à leur expertise pour accompagner les apprenants et leur permettre de progresser en passant à l’étape de formation suivante. Cette stratégie « d’évaluation aux fins d’apprentissage » est essentiellement une méthode d’enseignement, mais elle comporte aussi un volet d’évaluations de faible incidence. Toutes ces petites biopsies de rendement que vous recueillez sont autant de solides éléments de preuve que vous donnez au comité de compétence pour prendre une décision sur l’acquisition réussie d’une compétence par chaque résident. Par conséquent, il est important de former les superviseurs et les apprenants sur la façon de mener une évaluation en milieu de travail et de la documenter (c’est-à-dire, investir les ressources nécessaires et faire participer les intervenants) pour que les superviseurs évaluent les bonnes choses de la même façon (c’est-à-dire, pour que l’évaluation soit valide et répétable, donc fiable), et que les apprenants retirent autant d’avantages que possible de la rencontre clinique (c’est-à-dire, pour que les effets éducatifs de la rencontre soient maximisés).

5. Mener une évaluation du programme

En éducation, l’évaluation des programmes consiste à analyser une activité d’apprentissage dans son ensemble, qu’il s’agisse d’une conférence, d’un stage ou de tout un programme de résidence. Là encore, quelle que soit l’activité que vous tentez d’évaluer, votre objectif sera d’essayer de répondre aux mêmes questions de base : Est-ce qu’elle fonctionne? Pourquoi? Qu’est-ce qui a bien fonctionné? Que peut-on améliorer?

Pour répondre à la première question, le cadre formel le plus couramment appliqué à l’analyse des résultats d’une activité est le modèle de Kirkpatrick d’évaluation des résultats ou une de ses adaptations8 :

- Les apprenants ont-ils aimé l’activité? (Ils sont venus, ils ont participé et ils étaient satisfaits.)

- Les apprenants ont-ils appris quelque chose? (Leurs connaissances, leurs aptitudes ou leur attitude se sont améliorées.)

- Les apprenants ont-ils modifié leurs comportements? (Ils ont mis en application leurs nouvelles aptitudes dans la réalité.)

- Les apprenants ont-ils amélioré le devenir des patients? (L’amélioration de leurs comportements a produit de meilleurs soins.)

Chaque composante importe et elles sont toutes reliées entre elles, mais il est difficile de déterminer si le devenir des patients ou même des comportements ont changé précisément grâce à une activité d’apprentissage précise. En outre, l’effort requis pour faire cette démonstration est généralement entrepris dans le cadre d’un projet de recherche et ne fait pas partie du travail quotidien d’un directeur de programme. Il convient donc de créer des évaluations bien conçues qui ciblent la satisfaction et l’apprentissage des apprenants. Il convient de signaler que certaines activités éducatives, comme la formation sur la sécurité culturelle et la lutte contre le racisme, placent délibérément les participants hors de leur zone de confort, ce qui donne souvent lieu à une réflexion personnelle et éventuellement, à un changement de comportement. Il importe alors de faire appel à des animateurs chevronnés, qui seront mieux en mesure d’évaluer le lien entre le degré d’inconfort et des notes éventuellement moins élevées.

Pour avoir une vue d’ensemble de votre intervention d’apprentissage ou de votre programme d’études, vous devez l’observer sous l’angle de l’amélioration continue de la qualité. Si vous considérez uniquement le résultat, vous n’aurez pas une meilleure compréhension de ce qui fonctionne mal pour pouvoir apporter les corrections nécessaires ou améliorer vos stratégies qui sont déjà des réussites. Par exemple, si le rendement des apprenants ne s’est pas amélioré, il est possible que ce soit parce que le formateur a manqué de temps pour préparer la séance, que les apprenants n’ont pas assisté à la séance ou que la méthode d’évaluation était inadéquate. Le modèle logique est une des multiples approches d’évaluation de programmes4,9. Il vous permet d’obtenir un aperçu instantané de votre programme et de déterminer l’orientation souhaitée de vos projets d’évaluation et d’amélioration. Le modèle logique analyse les éléments suivants :

- Les intrants : les ressources disponibles, dont le temps, le personnel et le matériel;

- Les activités : toutes les activités planifiées, dont la publicité, les séances de formation et les évaluations;

- Les extrants : toutes les activités qui se sont réellement déroulées, y compris le moment et le type de diffusion de la publicité, le nombre de participants à l’activité et le nombre de personnes ayant répondu aux évaluations;

- Les résultats : à court et à long terme, sans omettre les résultats d’apprentissage attendus comme dans le modèle de Kirkpatrick, et les résultats inattendus.

Définir vos activités d’apprentissage de manière logique facilitera la planification, le déploiement, l’évaluation, l’amélioration et la promotion de votre programme.

L’évaluation du programme conclut le cycle de conception des programmes d’études en cinq étapes et il vous aide à préparer le prochain cycle. Par définition, l’exercice est une analyse rétrospective du processus de conception et il pose les questions suivantes :

- Pouvons-nous prouver que les apprenants ont atteint les résultats d’apprentissage souhaités?

- La méthode d’enseignement était-elle conçue pour répondre aux objectifs d’apprentissage et a-t-elle été appliquée comme prévu?

- Les objectifs d’apprentissage étaient-ils conçus spécifiquement pour répondre aux besoins des apprenants?

- Les besoins du public cible étaient-ils clairement cernés et pertinents pour le problème de départ?

- Avons-nous résolu le problème? Sinon pourquoi et quelles seront les prochaines étapes?

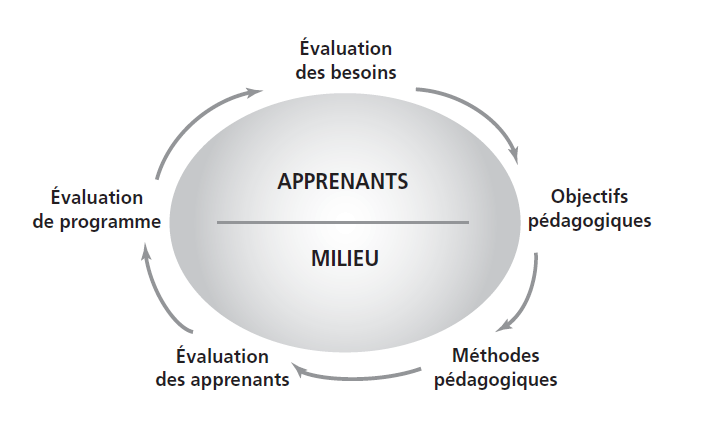

Graphique 5.1

Sherbino J et Frank JR (rédacteurs). Conception des programmes d'etudes : un guide CanMEDS pour les professions de la santé. Ottawa : Collége royal des médecins et chirurgiens du Canada, 2011.

Conseils et défis

Conseils

- Concentrez-vous sur l’objectif final ou l’objectif réel, plutôt que sur les objectifs secondaires ou les étapes et activités pour atteindre l’objectif final.

- Posez le bon diagnostic avant d’amorcer un processus exigeant en ressources.

- Ne vous méprenez pas : aucune activité d’apprentissage n’est efficace en soi. Elle nécessite un dialogue avec l’auditoire. L’absence d’une bonne évaluation des besoins est à l’origine de la plupart des activités d’apprentissage inefficaces et des pires.

- Évaluez votre évaluation et appliquez l’acronyme CARVE pour dégager la solution.

- Collaborez, ne réinventez pas, soyez logiques et passionnés.

Défis

- Le temps : le vôtre!

- Le temps : celui de vos collègues et de vos résidents!

- Le temps et encore le temps!

Conclusion

Le processus de conception de programmes d’études en cinq étapes et une façon efficace d’atteindre les objectifs d’apprentissage escomptés. Cela étant, il s’agit d’un processus, ce qui signifie qu’il exige du temps pour être amélioré : il ne s’agit pas là du passage naturel des mois et des années, mais du nombre de fois que vous appliquerez le processus, et d’une ressource que vous investirez dans la conception, le déploiement, l’évaluation et l’analyse du programme et du processus lui-même. Voyez grand, mais commencez petit. Si vous débutez dans le domaine, commencez par évaluer les besoins, essayez une méthode d’enseignement différente ou appliquez un nouvel outil d’évaluation, et bâtissez vos compétences. Nous avons la chance de compter quantité de formateurs cliniciens qualifiés au pays, il ne fait aucun doute que vous découvrirez au sein de votre établissement des collègues imaginatifs qui pourront être vos mentors. À force de négocier, de gérer et d’investir votre ressource la plus précieuse, le processus pour mener à bien une conception adéquate de programmes d’études finira par devenir une habitude pour vous, et vous vous retrouverez au cœur d’un cycle fructueux : votre programme s’améliorera, moins de correctifs seront nécessaires, les compétences du corps professoral seront plus étendues, comme les vôtres. Votre équipe et vous-même vous sentirez en confiance et investis, de nouvelles occasions professionnelles s’ouvriront à vous, etc. Lancez-vous dans l’aventure en visualisant ces résultats et amusez-vous en chemin!

Pour aller plus loin

- Sherbino J, Frank JR, rédacteurs. Conception des programmes d’études – Un guide CanMEDS pour les professions de la santé. Ottawa : Collège royal des médecins et chirurgiens; 2011.

Le B.A. ba. Il s’agit d’un guide étape par étape sur la conception des programmes d’études qui détaille chacun des thèmes abordés dans le présent chapitre. Il offre des outils très pratiques et expose leurs indications spécifiques, leurs contre-indications, leurs avantages et leurs désavantages. Il contient également une section complète sur le déploiement des programmes.

- Thomas PA, Kern DE, Hughes MT, Chen BY, editors. Curriculum development for medical education: a six-step approach. Baltimore: Johns Hopkins University Press; 2016.

Un classique (en anglais). Il présente l’approche désignée sous le nom de cycle de Kern et intègre le déploiement comme une des étapes de la conception de programmes d’études. Vous y trouverez un point de vue légèrement différent qui vous aidera à forger le vôtre.

- Van Der Vleuten CP. The assessment of professional competence: developments, research and practical implications. Adv Health Sci Educ. 19961(1):41–67.

Une analyse en profondeur (en anglais). Dans cet article fondamental, Van Der Vleuten présente, décrit et détaille son cadre conceptuel d’évaluation intégrant les cinq composantes de l’acronyme CARVE. Cette référence, peut-être un peu plus dense que les autres, constitue un bon suivi pour quiconque souhaite plonger dans les détails de l’évaluation après la lecture d’ouvrages sur la conception des programmes d’études.

- Kellogg WK. Logic model development guide. East Battle Creek (MI): W.K. Kellogg Foundation; 2004.

Un outil (en anglais). Le guide de Kellogg est une source inestimable pour quiconque souhaite commencer à appliquer le modèle logique pour planifier, déployer et évaluer des activités d’apprentissage. C’est un outil tout-en-un. À la fois complet et pratique, il deviendra un pilier de votre bibliothèque (réelle et virtuelle).

- Van Melle E. Using a logic model to assist in the planning, implementation, and evaluation of educational programs. Acad Med. 2016;91(10):1464.

Une page (en anglais). Une fois familiarisé avec le modèle logique, vous ne résisterez pas à accrocher cette page au mur pour y jeter un œil à loisir pendant la phase de conception ou pour vous remémorer la vue d’ensemble.

Résolution du scénario initial

Le Dr Tremblay décide d’analyser cette APC en profondeur en se penchant sur les évaluations individuelles. Malheureusement, il y a très peu de commentaires à propos des lacunes d’apprentissage et quasiment aucune suggestion d’amélioration. Il décide d’organiser des groupes de discussion séparés pour les résidents et pour les superviseurs afin de mieux comprendre le problème. Il découvre que les résidents n’obtiennent aucune rétroaction après avoir fait une présentation à une réunion de comité de thérapie du cancer. Les superviseurs signalent que les résidents ne savent pas comment personnaliser leur présentation pour un auditoire précis, qu’ils donnent trop de détails et de renseignements sur la pathologie, ce qui n’est pas pertinent pour la prise de décision. Le Dr Tremblay pense que la meilleure solution consiste à former le personnel sur la façon d’accompagner les résidents. En collaboration avec la Dre Nguyen, le Dr Tremblay décide d’organiser une séance d’information obligatoire sur les réunions de comité de thérapie du cancer pour les résidents à l’étape de maîtrise de la discipline. Ils commencent par recueillir la rétroaction multisource pour évaluer le rendement des résidents lors de ces réunions. La Dre Nguyen anime un atelier de perfectionnement du corps professoral et y intègre des démonstrations, des discussions de cas et des jeux de rôles. Après trois mois, ils organisent une séance de suivi pour partager les pratiques exemplaires et les défis rencontrés. Après six mois, ils envoient un questionnaire d’évaluation sur le programme aux résidents et aux superviseurs. Le Dr Tremblay est impatient d’en analyser les réponses et d’établir des liens entre les résultats de la rétroaction multisource et les évaluations de l’APC dans le tableau de bord.

Références

- Sherbino J, Frank JR, rédacteurs. Conception des programmes d’études – Un guide CanMEDS pour les professions de la santé. Ottawa : Collège royal des médecins et chirurgiens; 2011.

- Frank JR, Snell LS, ten Cate O, Holmboe ES, Carraccio C, Swing SR, et al. Competency-based medical education: theory to practice. Med Teach. 2010;32(8):638–45.

- Thomas PA, Kern DE, Hughes MT, Chen BY, editors. Curriculum development for medical education: a six-step approach. Baltimore: Johns Hopkins University Press; 2016.

- Kellogg WK. Logic model development guide. East Battle Creek (MI): W.K. Kellogg Foundation; 2004.

- Krathwohl DR. A revision of Bloom’s taxonomy: an overview. Theory Pract. 2002;41(4):212–8.

- Yudkowsky R, Park YS, Downing SM, editors. Assessment in health professions education. New York (NY): Routledge; 2019.

- Van Der Vleuten CP. The assessment of professional competence: developments, research and practical implications. Adv Health Sci Educ. 1996;1(1):41–67.

- Kirkpatrick D, Kirkpatrick J. Evaluating training programs: the four levels. San Francisco: Berrett-Koehler Publishers; 2006.

- Van Melle E. Using a logic model to assist in the planning, implementation, and evaluation of educational programs. Acad Med. 2016;91(10):1464.